Top Themen in der KI-Compliance:

AI Governance umfasst alle Richtlinien, Prozesse und Strukturen zur verantwortungsvollen Steuerung künstlicher Intelligenz. Ein KI-Beauftragter schafft Rechtssicherheit, minimiert Risiken und bildet die Grundlage für nachhaltige KI-Nutzung in Unternehmen jeder Größe.

Montagmorgen, neun Uhr. Die Marketingleiterin nutzt einen KI-Assistenten für Produktbeschreibungen. Der Vertrieb speist Kundendaten zur Leadbewertung ein. Die Buchhaltung experimentiert mit automatisierter Rechnungserkennung. Das Problem: Die Geschäftsführung weiß von alledem nichts.

Dieses Szenario ist 2026 kein Einzelfall, sondern der Standard. Laut Bitkom-Studie zur KI-Nutzung nutzen bereits 42 Prozent der deutschen Unternehmen KI-Anwendungen. Die wenigsten haben jedoch systematisch erfasst, wie und wo diese eingesetzt werden. Das rächt sich spätestens bei Datenschutzvorfällen oder Verstößen gegen die KI-Verordnung.

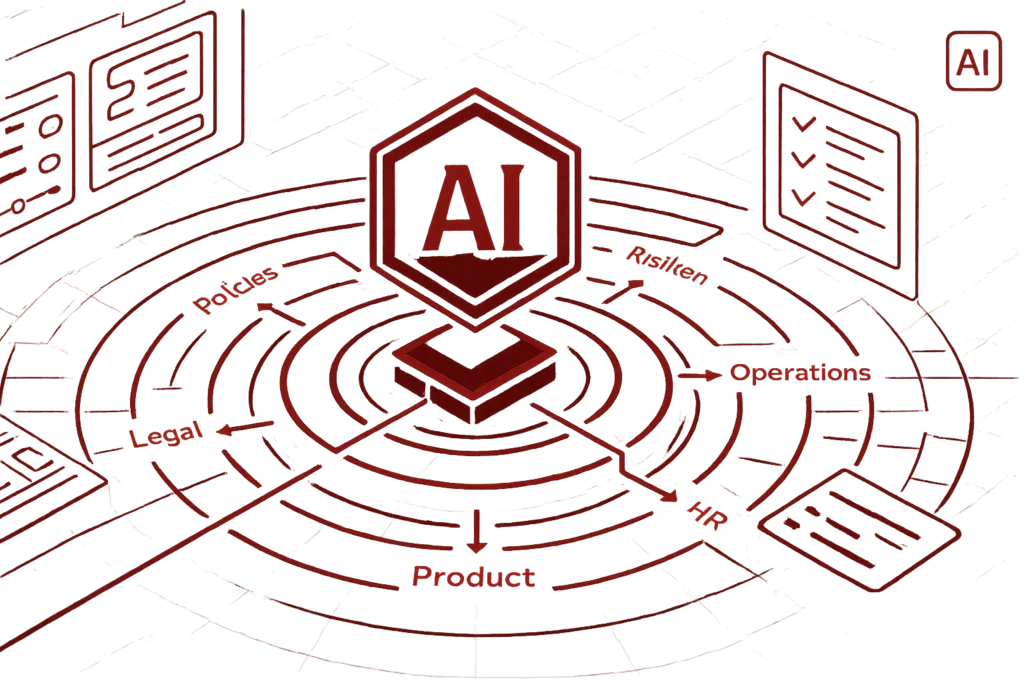

AI Governance liefert die Antwort auf eine zentrale Frage: Wer ist verantwortlich für das, was KI im Unternehmen macht? Ohne klare Strukturen, Richtlinien und Prozesse ist weder Risikobewertung noch Compliance-Nachweis möglich.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenKI Governance bezeichnet alle organisatorischen, technischen und rechtlichen Maßnahmen, mit denen Unternehmen die Entwicklung und Nutzung von KI-Systemen steuern, überwachen und kontinuierlich verbessern. Das Framework bildet die Grundlage für verantwortungsvolle, ethische und rechtskonforme KI-Nutzung. Internationale Standards wie ISO/IEC 42001 definieren Anforderungen an KI-Managementsysteme.

Im Kern beantwortet AI Governance drei Fragen: Welche KI-Systeme werden eingesetzt? Wer trägt die Verantwortung? Welche Regeln gelten für den Umgang damit? Die Antworten fließen in ein strukturiertes Managementsystem ein, das Transparenz schafft und Risiken minimiert.

Anders als beim klassischen IT-Management geht es bei KI Governance nicht nur um technische Aspekte. Ethische Fragen, gesellschaftliche Auswirkungen und regulatorische Anforderungen spielen eine gleichwertige Rolle. Diese Mehrdimensionalität macht KI Governance zur Querschnittsaufgabe für das gesamte Unternehmen.

Drei Regelwerke bilden das regulatorische Fundament für AI Governance in Deutschland und Europa. Sie greifen ineinander und stellen unterschiedliche Anforderungen an Unternehmen. Eine detaillierte Übersicht bietet der Leitfaden zur KI-Verordnung.

Die DSGVO verlangt Transparenz für jede Verarbeitung personenbezogener Daten. Das gilt auch für KI-Systeme, die mit Kundendaten, Mitarbeiterinformationen oder anderen personenbezogenen Daten arbeiten. Artikel 22 DSGVO regelt zudem automatisierte Entscheidungen: Betroffene haben das Recht, nicht einer ausschließlich auf automatisierter Verarbeitung beruhenden Entscheidung unterworfen zu werden, die rechtliche Wirkung entfaltet. Für KI-gestützte Prozesse bedeutet das: Menschliche Überprüfung muss möglich sein.

Der EU AI Act tritt ab August 2026 vollständig in Kraft und klassifiziert KI-Systeme nach Risikostufen. Hochrisiko-Systeme in Bereichen wie Personalwesen, Kreditvergabe oder kritische Infrastruktur unterliegen umfassenden Dokumentations- und Transparenzpflichten. Die Verordnung sieht bei Verstößen Bußgelder von bis zu 35 Millionen Euro oder 7 Prozent des globalen Jahresumsatzes vor. Verbotene KI-Praktiken wie Social Scoring oder manipulative Systeme sind bereits seit Februar 2025 untersagt.

Die NIS2-Richtlinie verpflichtet kritische Sektoren zu systematischem Risikomanagement. Unternehmen aus Bereichen wie Energie, Gesundheit, Finanzwesen oder digitale Infrastruktur müssen Cybersicherheitsmaßnahmen nachweisen. KI-Systeme fallen in diesen Rahmen, sobald sie sicherheitsrelevante Funktionen übernehmen oder in kritischen Prozessen eingesetzt werden.

Effektive KI Governance basiert auf sechs Kernprinzipien, die den verantwortungsvollen Umgang mit künstlicher Intelligenz sicherstellen.

Alle Beteiligten müssen verstehen, wie KI-Systeme funktionieren und welche Entscheidungen sie treffen. Das umfasst sowohl die technische Dokumentation als auch verständliche Erklärungen für Endnutzer und Betroffene. Transparenz schafft Vertrauen und ermöglicht die Überprüfbarkeit von KI-Entscheidungen.

Für jedes KI-System muss klar definiert sein, wer die Verantwortung trägt. Das betrifft sowohl die technische Umsetzung als auch ethische und rechtliche Aspekte. Eine klare Zuordnung verhindert Verantwortungsdiffusion und stellt sicher, dass Probleme schnell adressiert werden.

KI-Systeme verarbeiten häufig große Mengen an Daten, darunter auch personenbezogene Informationen. Die Einhaltung der DSGVO und weiterer datenschutzrechtlicher Vorgaben ist nicht verhandelbar. Datenminimierung, Zweckbindung und technische Schutzmaßnahmen müssen von Anfang an integriert werden.

KI-Systeme dürfen keine Diskriminierung verstärken oder neue Formen der Benachteiligung schaffen. Verzerrungen in Trainingsdaten können zu unfairen Ergebnissen führen. Regelmäßige Überprüfungen auf Bias und diskriminierende Muster sind daher essenziell.

KI-Systeme müssen robust gegen Angriffe und Manipulationen sein. Cybersicherheitsmaßnahmen schützen vor unbefugtem Zugriff, Datenlecks und adversarial attacks. Die Systemintegrität muss über den gesamten Lebenszyklus gewährleistet sein.

Die Ergebnisse von KI-Systemen müssen regelmäßig überprüft und validiert werden. Qualitätskontrollen stellen sicher, dass die Systeme wie vorgesehen funktionieren und keine unerwarteten Fehler produzieren. Kontinuierliches Monitoring und Anpassungen sind Teil des Governance-Prozesses. Eine KI-Kompetenz-Schulung vermittelt Mitarbeitenden das nötige Wissen für den verantwortungsvollen Umgang mit KI.

Effektive KI Governance erfordert klare organisatorische Strukturen. Die folgenden Rollen bilden das Rückgrat eines funktionierenden Governance-Frameworks. Besonders wichtig ist die Position des AI Officers als strategischer Verantwortlicher.

Rolle | Aufgaben |

|---|---|

Chief AI Officer (CAIO) | Strategische Gesamtverantwortung für KI-Initiativen, Abstimmung mit Geschäftsführung |

AI Governance Board | Steuerung, Richtlinienentwicklung, Freigabe von KI-Projekten |

Compliance-Team | Überwachung regulatorischer Vorgaben, Auditierung, Dokumentation |

Fachbereichsverantwortliche | Meldung von KI-Nutzung, Einhaltung der Richtlinien im Tagesgeschäft |

Ein vollständiges KI-Inventar erfasst alle Systeme mit KI-Funktionen im Unternehmen. Dazu gehören nicht nur eigenständige KI-Anwendungen, sondern auch eingebettete KI in CRM-, HR- oder ERP-Systemen. Die systematische Erfassung bildet die Grundlage für Risikobewertung und Compliance-Nachweis.

Schritt 1: Fragebogen an Fachabteilungen

Verteilen Sie einen standardisierten Fragebogen an alle Abteilungen. Fragen Sie allgemein, ob Software genutzt wird, die automatisierte oder eigenständige Entscheidungen trifft. Die Formulierung sollte bewusst offen sein, um auch unbewusste KI-Nutzung zu erfassen.

Schritt 2: IT-gestützte Analyse

Ergänzen Sie die Befragung durch technische Analysen. Software-Asset-Management-Tools können KI-Komponenten in bestehenden Anwendungen identifizieren. Netzwerkanalysen zeigen Verbindungen zu externen KI-Diensten auf.

Schritt 3: Kategorisierung nach Risikoklassen

Ordnen Sie jedes identifizierte System einer Risikoklasse zu: minimal, begrenzt, hoch oder verboten. Die Klassifizierung richtet sich nach dem EU AI Act und bestimmt die erforderlichen Governance-Maßnahmen.

Schritt 4: Dokumentation der Datenflüsse

Erfassen Sie für jedes System, welche Daten eingehen, wie sie verarbeitet werden und welche Ergebnisse produziert werden. Diese Dokumentation ist sowohl für die DSGVO als auch für den AI Act relevant.

Schritt 5: Regelmäßige Aktualisierung

Das KI-Inventar ist kein einmaliges Projekt. Etablieren Sie einen Prozess zur kontinuierlichen Aktualisierung. Neue KI-Systeme müssen vor der Einführung gemeldet und bewertet werden.

Eines der größten Risiken für Unternehmen ist Schatten-KI: die Nutzung von KI-Tools unterhalb des Radars der IT-Abteilung. Kostenlose ChatGPT-Zugänge, Bildgeneratoren oder KI-gestützte Übersetzungstools werden oft ohne Freigabe eingesetzt.

Das Problem: Vertrauliche Unternehmensdaten können in die Hände von Drittanbietern gelangen. Mitarbeitende laden Kundenlisten, Vertragsdetails oder strategische Dokumente in externe KI-Systeme hoch, ohne sich der Konsequenzen bewusst zu sein. Die Daten werden häufig für das Training der KI-Modelle verwendet und sind damit dauerhaft außerhalb der Unternehmenskontrolle.

Gegenmaßnahmen:

Eine unternehmensinterne KI-Richtlinie ist zentral für die Umsetzung der gesetzlichen Anforderungen. Sie definiert verbindliche Regeln für alle Mitarbeitenden und schafft Klarheit im Umgang mit KI-Systemen. Ein Leitfaden zur Entwicklung von KI-Richtlinien unterstützt bei der praktischen Umsetzung.

Empfehlung: Dreiteilung der Software-Kategorien

Die Richtlinie sollte zusätzlich regeln:

Unser spezialisiertes KI Audit unterstützt Sie bei der Bewertung und Steuerung von KI-Systemen in Ihrem Unternehmen – für rechtskonforme und verantwortungsvolle AI Governance.

AI Governance ist nicht nur regulatorische Pflicht, sondern auch wirtschaftlich sinnvoll. Unternehmen mit etablierten Governance-Frameworks profitieren mehrfach.

Die Deutsche Telekom zeigt, dass proaktive KI-Governance funktioniert: Bereits 2018 etablierte das Unternehmen eigene AI-Guidelines. Als der AI Act kam, war die Telekom vorbereitet, weil Governance längst zum Alltag gehörte.

KI Governance bezeichnet alle Richtlinien, Prozesse und Strukturen, mit denen Unternehmen den Einsatz künstlicher Intelligenz steuern, überwachen und verantwortungsvoll gestalten. Das Framework umfasst organisatorische, technische und rechtliche Maßnahmen.

Die strategische Gesamtverantwortung liegt idealerweise bei einem Chief AI Officer (CAIO) oder einer vergleichbaren Position. Ein AI Governance Board steuert die Richtlinienentwicklung, während das Compliance-Team die Einhaltung regulatorischer Vorgaben überwacht.

Drei Regelwerke sind zentral: Die DSGVO regelt den Umgang mit personenbezogenen Daten in KI-Systemen. Der EU AI Act klassifiziert KI nach Risikoklassen und definiert spezifische Pflichten. Die NIS2-Richtlinie fordert Risikomanagement in kritischen Sektoren.

Schatten-KI bezeichnet die Nutzung von KI-Tools ohne Wissen der IT-Abteilung. Mitarbeitende nutzen kostenlose Dienste wie ChatGPT und laden dabei oft vertrauliche Unternehmensdaten hoch. Diese Daten können für das Training der KI verwendet werden und sind dauerhaft außerhalb der Unternehmenskontrolle.

Starten Sie mit einem standardisierten Fragebogen an alle Fachabteilungen. Fragen Sie, ob Software genutzt wird, die automatisierte Entscheidungen trifft. Ergänzen Sie die Befragung durch IT-gestützte Analysen und kategorisieren Sie die identifizierten Systeme nach Risikoklassen.

Der EU AI Act sieht gestaffelte Bußgelder vor: Bis zu 35 Millionen Euro oder 7% des globalen Jahresumsatzes für Verstöße bei verbotenen KI-Praktiken. Bei anderen Verstößen können bis zu 15 Millionen Euro oder 3% des Umsatzes fällig werden.

Der AI Act tritt stufenweise in Kraft. Verbotene KI-Praktiken sind seit Februar 2025 untersagt. Die vollständigen Anforderungen für Hochrisiko-Systeme gelten ab August 2026. Unternehmen sollten bereits jetzt mit der Umsetzung beginnen.

Profitieren Sie von der Expertise unserer TÜV-zertifizierten KI-Experten, die Ihnen als externer KI-Beauftragter zur Seite stehen.

Wir begleiten Unternehmen dabei, Künstliche Intelligenz rechtssicher, transparent und verantwortungsvoll einzusetzen – digital, praxisnah und zu fixen Konditionen. Ob Risikobewertung nach EU AI-Act oder in der Schulung Ihrer Mitarbeitenden – Wir sorgen dafür, dass der Einsatz von KI-Systemen in Ihrem Unternehmen den regulatorischen Vorgaben entspricht und rechtliche Risiken minimiert werden.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen